**全文字数:**约 2600 字

**预计阅读时间:**约 10 分钟

**最后更新日期:**2025年08月25日

🤔 这篇文章适合你吗?

✅ 你对 AI Agent 架构有深入思考,并对当前流行的复杂框架感到困惑;

✅ 你被 LangChain、AutoGPT 等复杂的多 Agent 系统折磨过,渴望回归简单和本质;

✅ 你相信,最好的 Agent 设计,应该是最大化模型原生智能,而非堆砌复杂的工程脚手架。

📖 本文核心原则

**1. 引言:**AI Agent 领域的“巴别塔”困境

2. 原则一 (简约循环): 为什么一个主循环优于复杂的多 Agent 协作

3. 原则二 (赋能而非封装): LLM Search vs. RAG 的路线之争

4. 原则三 (结构化沟通): 将人类意图“编译”为机器语言

5. 原则四 (用户在环): 最好的 Agent 是“可被驾驭”的

6. 结语: 回归“惨痛的教训”

AI Agent的“第一性原理”:为什么Claude Code的“极简主义”能吊打复杂的Multi-Agent系统?

1. 引言:AI Agent 领域的“巴别塔”困境

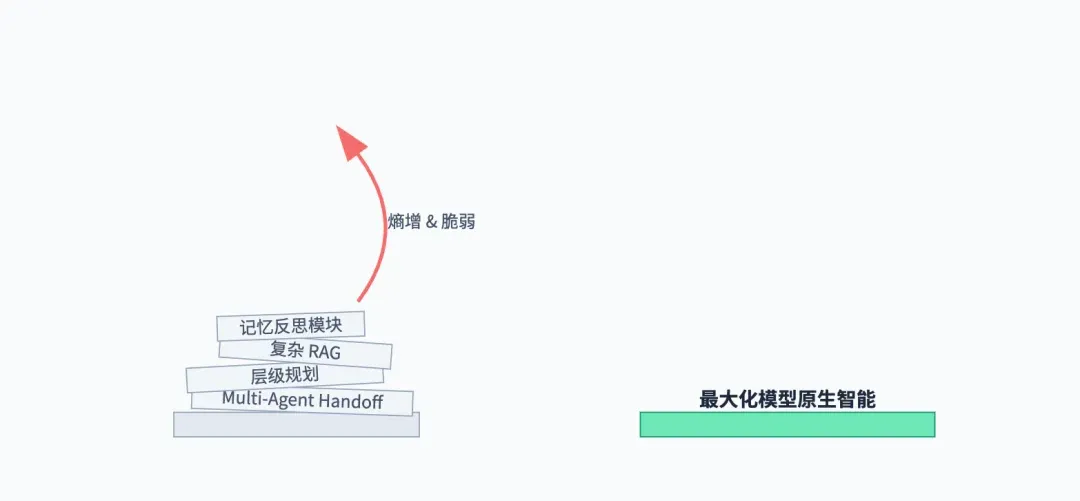

当前的 AI Agent 领域,让我联想到了圣经里的“巴别塔”故事。我们热衷于构建越来越复杂的系统——多 Agent 协作、层级规划、记忆反思……各种框架层出不穷,试图用精巧的工程学,去搭建一座通往“通用人工智能”的高塔。

然而,塔越高,系统就越脆弱,越难以调试。我们引入了太多的“中间商”——复杂的 Agent Handoff、难以解释的 RAG 检索、层层嵌套的 Prompt 链。每一个环节,都在增加系统的熵,都在扭曲和损耗模型原生的智能。我们离目标,似乎越来越远。

而 Claude Code 的出现,像一股清流。它的设计哲学,与当前的“炫技”潮流背道而驰,回归到了构建 Agent 的第一性原理:最大化模型的原生智能,最小化框架的额外复杂度。 今天,我将为你深度拆解 Claude Code 背后的“极简主义”设计哲学,并论证为什么这种看似“简单”的思路,在当前阶段,能够吊打绝大多数复杂的 Multi-Agent 系统。

原则一:简约的控制循环 — 可靠性压倒一切

当前许多 Agent 框架,痴迷于构建复杂的“协作图谱”。一个 PM Agent 生成需求,交给 Engineer Agent 编码,再由 QA Agent 测试。这听起来很美,但在实践中,每一次“交接”(Handoff)都是一次巨大的信息损耗和潜在的错误点。

Claude Code 的设计则极其克制:它只有一个主控制循环,一个扁平的消息历史。 即使需要处理分层任务,它也只是生成一个“最多一层”的、无状态的子代理,执行完后结果立刻并入主循环。

为什么“简约”更优?1. 可调试性 (Debuggability): 扁平的消息历史,意味着你可以清晰地追溯 Agent 的每一步思考。而复杂的多 Agent 系统,其内部状态和通信是巨大的黑箱,一旦出错,几乎无法调试。

2. 拥抱模型进化: 复杂的框架,本质上是在用工程学的“补丁”,去弥补当前模型的“智商”缺陷。而这些补丁,会让你无法享受到未来更强模型带来的红利。一个简单的循环,则能最大程度地受益于模型本身的迭代升级。

第一性原理: Agent 的可靠性和可预测性,远比其架构的“精巧”程度更重要。在 LLM 仍然是一个“概率性”存在的今天,最简单的控制结构,就是最鲁棒的。

原则二:赋能而非封装 — LLM Search vs. RAG 的路线之争

如何让 Agent 理解你的代码库?主流方案是 RAG(检索增强生成):将代码库向量化,存入数据库,然后进行语义搜索。这听起来很科学,但 Claude Code 选择了另一条更“野”的路:LLM Search。

它不搞什么向量数据库,而是直接把 grep, find, ls 这些最原始的命令行工具交给大模型,让模型自己决定如何去探索文件系统。这就像教人钓鱼,而不是直接给他鱼。

为什么“赋能”更优?1. 避免信息抽象损耗: RAG 的向量化过程,本身就是一种信息的“有损压缩”。而 LLM Search 让模型直接接触最原始的代码文本,保留了全部的上下文和细节。

2. 发挥模型原生智能: 最懂代码的,不是任何一种 embedding 算法,而是大模型自己。让模型用它最擅长的方式去理解代码,而不是强迫它接受 RAG “喂”给它的、经过二次加工的信息,效率和准确性反而更高。

第一性原理: 不要试图用复杂的工程学去“封装”和“简化”给模型的信息。相反,应该给予模型最原始、最完整的上下文,并赋能它使用基础工具去自主探索。相信模型的智能,而不是相信你的框架。

原则三:结构化沟通 — 将人类意图“编译”为机器语言

与 LLM 的沟通,本质上是一场“降噪”运动。模糊的自然语言,充满了歧义。Claude Code 的高明之处在于,它大量使用 XML 标签和角色扮演,将我们的意图,结构化为模型能精确理解的“指令”。

pytest /foo/bar/tests

cd /foo/bar && pytest tests

这不仅仅是简单的 Prompt Engineering。这是在模拟一个编译器的工作:将高级的人类语言(我们的需求),“编译”成低级的、无歧义的、机器可执行的中间代码(带有 XML 标签和角色的 Prompt)。

为什么“结构化”更优?第一性原理: LLM 的核心能力是“模式匹配”。通过提供结构化的、带有清晰边界(如 XML 标签)的输入,我们极大地降低了模型识别和执行我们意图的难度,从而提高了输出的稳定性和准确性。

原则四:用户在环 — 最好的 Agent 是“可被驾驭”的

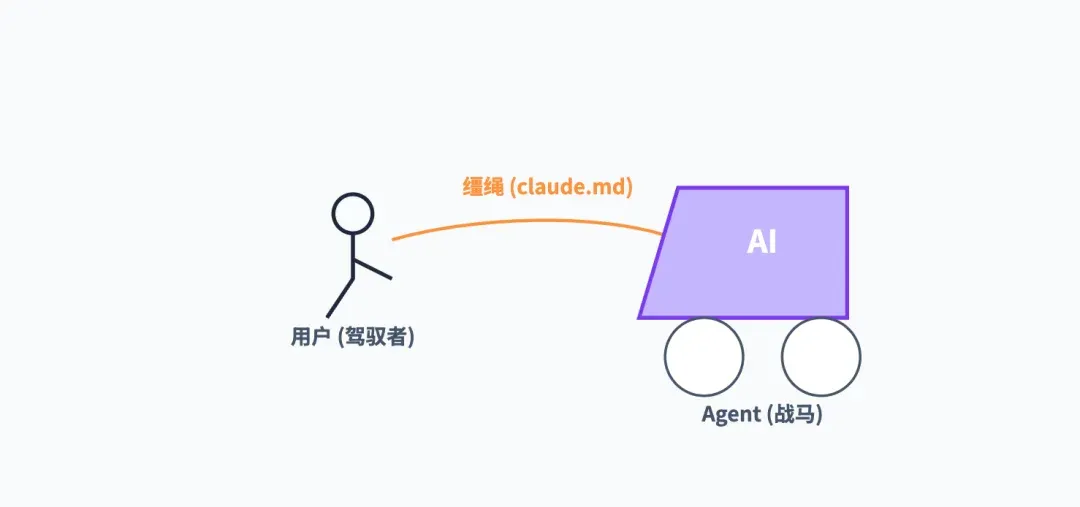

当前对 Agent 的一个巨大误解,是追求完全的“自主性”(Autonomy)。而 Claude Code 的设计,则处处体现了“用户在环”(Human-in-the-Loop)的哲学。

claude.md文件:

这是一个绝妙的设计。它给了用户一个“方向盘”,让用户可以通过一个持久化的文件,来定义 Agent 的行为偏好、代码规范、禁区等。这让 Agent 从一个“黑箱”,变成了一个可被“调教”和“塑造”的伙伴。

- Todo List 和 Plan Mode:

这些机制,强迫 Agent 在采取大规模行动前,必须先向用户“汇报计划”。这给了用户一个宝贵的“否决权”和“修正权”,避免了 Agent 埋头苦干半小时,结果却南辕北辙的惨剧。

为什么“可驾驭”更优?第一性原理: 在 AGI 到来之前,AI Agent 的核心价值,不是替代人类,而是增强人类。一个好的 Agent,应该像一匹训练有素的战马,强大但听从指挥;而不是一头无法控制的猛虎。可控性、可预测性、可干预性,是当前阶段衡量一个 Agent 是否“可用”的关键标准。

6. 结语:回归“惨痛的教训”

计算机科学家 Rich Sutton 有一篇著名的文章,叫《The Bitter Lesson》(惨痛的教训)。文章的核心观点是,70 年的人工智能研究史告诉我们,那些试图将人类知识硬编码进系统的复杂方法,最终都败给了基于海量计算的、通用的、可扩展的方法。

今天的 AI Agent 领域,正在重演这个故事。那些复杂的 Multi-Agent 框架,就像是试图用精巧的工程学去“教”AI 如何思考。而 Claude Code 的极简主义哲学,则回归了本质:相信并最大化利用大模型本身强大的、通用的学习和推理能力,只在必要的地方提供最轻量、最直接的引导。

这,或许就是构建下一个杀手级 AI Agent 的真正秘诀。

Less is More!

觉得果叔的分析有启发?点个「👍」,「转发」给更多需要系统化思考的朋友吧!

关注我的公众号,与你一同探索 AI、出海与数字营销的无限可能。

🌌 在通往 AGI 的路上,最强大的杠杆,永远是简约和第一性原理。