内容字数:约 3000 字

预计阅读时间:约 11 分钟

最后更新日期:2025年09月07日

本文核心脉络

1. 三大诅咒:揭示限制当前 AI Agent 的数学、经济与工程学原理。

2. 实践避坑:分享我在开发 Agent 中踩过的真实“大坑”。

3. 正确形态:定义 2025 年真正能落地、能盈利的 AI Agent——“超级工具”。

4. 三层评估模型:提供一个可供创业者和开发者直接使用的专业构建框架。

AI Agent 淘金热的真相:为什么 2025 年是“超级工具”的胜利,而非“全能管家”

引言:给狂热的 AI Agent 泼一盆“理性”的冷水

你好,我是果叔。如果你最近关注科技圈,一定会被 AI Agent 的狂热所包围。大 V 们高呼“贾维斯时代”即将来临,创业公司如雨后春笋般涌现,人人都在谈论“通用自主智能体”将如何颠覆世界。

但作为 AI 的深度实践者和产品顾问,我必须给这股狂热泼一盆理性的冷水:**这条通往“全能管家”的路,在 2025 年注定会撞上南墙。**这不是技术强弱的问题,而是由几个无法绕过的第一性原理——数学、经济学和工程学——所决定的。本文的目的,不是唱衰 AI,恰恰相反,是希望揭示真相,帮助我们这些真正想用 AI 搞事业的人,找到那条能走通、可盈利的正确道路。

第一章:数学的诅咒——“错误复合效应”与自主的幻觉

Agent 公司在产品演示里,最喜欢展示一个 5 步的简单任务和酷炫的结果,但他们绝不会告诉你一个魔鬼细节——“错误复合效应”。

这是一个简单却残酷的数学题:假设一个 Agent 执行单一步骤的准确率高达 95%(这在当前大模型中已是相当乐观的估计),那么,当它连续执行一个包含 20 个步骤的真实工作流时,最终成功完成整个任务的概率是多少?

答案是:0.95 的 20 次方 ≈ 36%

这意味着,你有近 三分之二的概率会得到一个失败的结果。再好的提示词也无法违背基础的数学规律。现在我反问你:你会雇佣一个有 64% 概率会搞砸关键业务的员工吗?答案不言而喻。

我曾亲身踩过这个坑。我开发过一个“自动化社媒内容分发 Agent”,在演示 5 步短流程(选题 -> 生成文案 -> 生成图片 -> 发布 -> 通知)时完美无缺。但在实际应用的 20 步长流程(增加监控热点、多平台适配、评论情感分析、自动回复等)中,失败率高得惊人,最终沦为一个需要时刻盯着的“半成品”,远不如拆分成几个独立的、可靠的工具好用。

**战略结论:**放弃对“端到端全自动”的执念。可靠的 Agent 必须被设计成由 3-5 个可被独立验证的短步骤组成,并在关键节点设置人工检查与确认机制。

第二章:经济的黑洞——“平方成本诅咒”与商业模式的崩溃

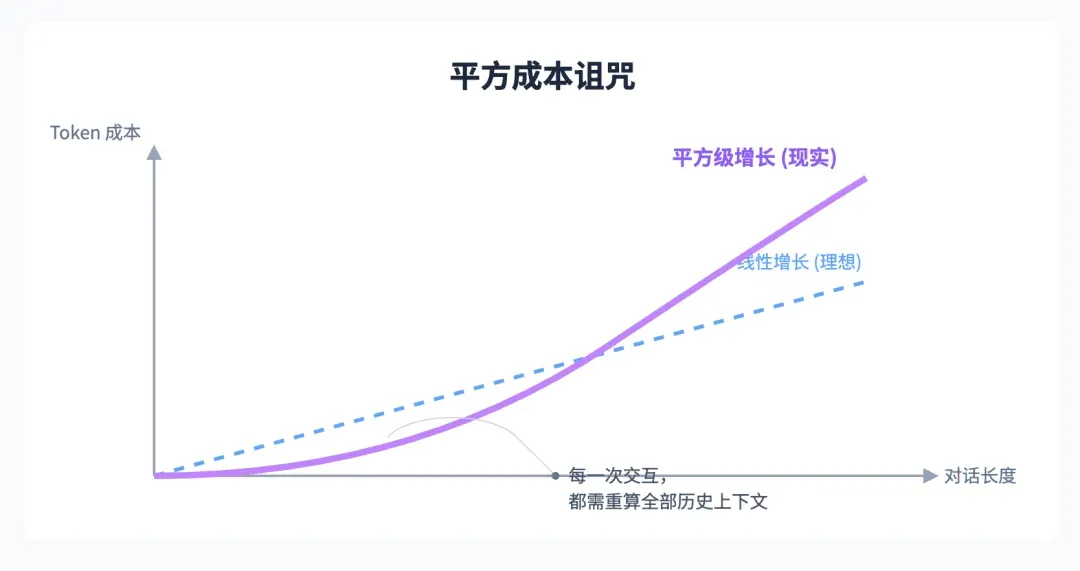

如果说数学问题决定了 Agent 的可靠性,那么经济学问题则直接决定了它的生死存亡。所有鼓吹“长程多轮对话”的 Agent,都隐藏着一个恐怖的经济学模型——“平方成本诅咒”。

打个比方,这就像你坐上了一辆天价出租车:它每开一小段新路,计价器不仅计算这段新路的费用,还会把你走过的所有历史路径的费用再重新计算一遍。因为 Agent 为了理解上下文,每一次交互,都必须把全部历史对话记录重新处理。

所以,对话越长,Token 成本不是线性增加,而是像滚雪球一样,呈平方级爆炸式增长。一个看似普通的 100 回合对话,光是 API 调用成本就可能高达几十甚至上百美元。这就是为什么最强的 AI 编程工具 Cursor 不得不持续涨价,而 Claude Code 也在近期开始严格限制用量。

我早期尝试做一个“对话式 BI 数据分析 Agent”时,曾因成本问题被迫放弃。而近期在使用 Claude Code 这类编程智能体时,感受则更为直观:**做一个非常简单的前端项目,一个小时随随便便就会用掉 10M 以上的 Tokens(包括上下文缓存)。**这还只是单个 Agent 的情况,如果为了追求效率,使用 Sub Agent 同时跑并行任务,Tokens 的消耗会瞬间从“水管”变成“瀑布”。我订阅的 200 美元套餐,在这种强度下,几天就会耗尽配额。这门生意根本做不下去。

**战略结论:**优先设计“无状态”(Stateless) 的 Agent。让它成为一个专注的工具人,一次调用,一次高质量输出,然后立刻“下班”。没有上下文的持续叠加,就没有商业模式的崩溃。

第三章:工程的真相——“工具为王”与 AI 的 30% 价值

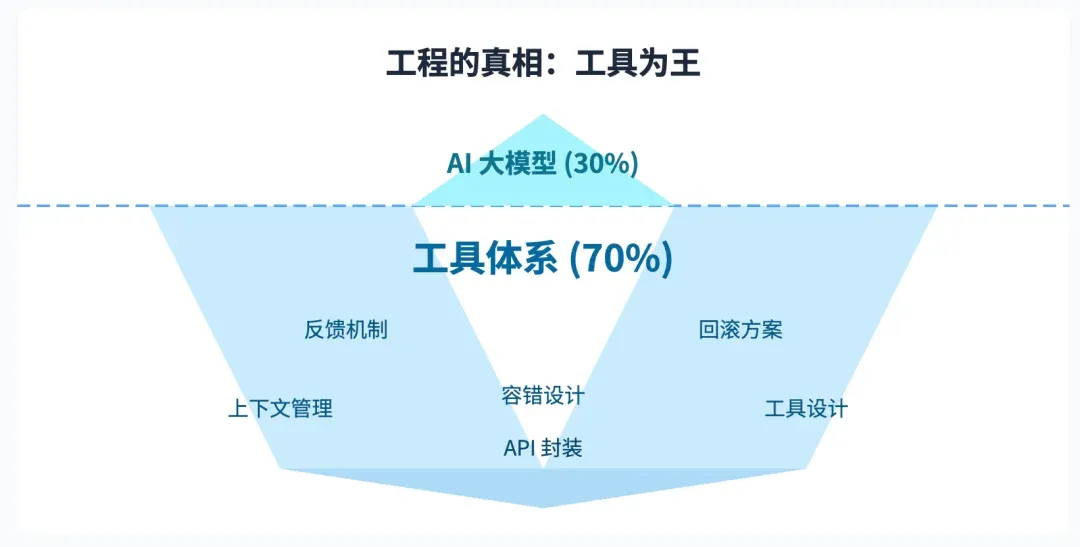

一个更颠覆你认知的真相是:在一个成功的 Agent 系统里,那个聪明绝顶的 AI 大脑,可能只完成了 30% 的工作。

那剩下的 70% 是什么?是那些看起来毫不起眼、又苦又累的工程任务:为 AI 设计它能理解的工具、构建清晰的反馈机制、处理失败的回滚方案、管理上下文……这套**“工具体系”**,才是真正的护城河。

从产品顾问的视角,我们可以解构一下 Claude Code 为什么如此强大。你可以试试,即便把它底层的模型换成另一个优秀的开源模型,它的表现依然远超竞品。因为它真正的壁垒,是那套为代码任务量身定制的、极其完善的工具体系和工程架构。它知道如何分解任务、如何调用文件系统、如何执行测试,并在每一步都设计了清晰的反馈闭环。

如果你听到有公司说“我们的 Agent 能自动连接 API 搞定一切”,那他们要么是在吹牛,要么就是没亲自下场做过。

**战略结论:**将你的大部分精力,投入到为 AI 设计又苦又累的工具上。思考:成功时如何用最少的 Token 反馈结果?失败时如何用最精准的信息告诉 AI 错在哪里?这才是构建可用 Agent 的核心壁垒。

第四章:拨开迷雾——构建“超级工具”的三层评估模型

基于以上三大原理的约束,我们可以清晰地定义出 AI Agent 在 2025 年唯一能真正落地的形态——它不是“全能管家”,而是一系列**“超级辅助工具”**。而要构建一个成功的“超级工具”,我们需要一个系统化的评估框架。这套框架源于我技术合伙人 Tam 在顶级 AI 公司面试时总结的工程哲学,我将其提炼为三个核心层次:

第一层:资源效率与计算经济学 (Efficiency & Economics)

这是 Agent 的生存基础。一个超出计算预算或响应太慢的 Agent,不具备任何生产价值。我们必须量化: • 推理成本:精确核算单次任务的 Token 消耗,目标是在保证效能的前提下最小化成本。 • 响应时延:关注 TTFT (首字符时间) 和端到端总时间,确保用户体验流畅。 • 执行开销:分析工具调用的成本和效率。这直接对应了我们之前提到的“成本可控”原则。

第二层:任务效能与确定性 (Effectiveness & Determinism)

通过了经济性评估,我们才能聚焦于它的核心价值:任务完成的质量。我们必须建立: • 任务成功率:基于一个“黄金基准测试集”来量化 Agent 的可靠性。 • 结果质量:自动化计算幻觉率和指令遵循精确度,确保输出可用。 这对应了“明确界限”和“可靠性 > 自主性”原则。一个边界清晰、结果可预测的工具,远胜于一个偶尔惊艳但经常失控的自主系统。

第三层:系统稳健性与可观测性 (Robustness & Observability)

一个只能在理想条件下运行的 Agent 是脆弱的。作为生产级系统,它必须具备: • 系统稳健性:通过注入异常输入,测试其能否优雅降级,而非直接崩溃。 • 可观测性:当行为异常时,我们能否通过日志和轨迹快速定位根源? 这层评估直接关联了“容错设计”原则,确保我们的 Agent 不是一个不可维护的“黑箱”。而“混合架构”的理念贯穿始终:用 AI 处理模糊性,用传统代码的确定性来保障系统的稳健和可观测。

结语:忘掉贾维斯,拥抱更聪明的“锤子”

所以,AI Agent 没用了吗?不,恰恰相反。它的革命一定会到来,但其形态绝不是科幻电影里的神话。

你可以忘了那个能帮你从头到尾写一本书的 Agent,它不靠谱;但一个能帮你检查语法、优化风格、提供引用建议的**“写作助手”**,能实实在在地让你的效率提升 10 倍。

你也可以忘了那个能帮你全自动炒币的 Agent,它可能会让你倾家荡产;但一个能 7x24 小时监控市场、分析消息面、在你设定的异动发生时第一时间告警的**“投研助手”**,则可能是无价之宝。

我们应该去构建的,是那些边界严格、任务专注、成本可控、且人类掌握最终控制权的“超级辅助工具”。让 AI 处理复杂性,让人类掌握控制权。这,才是 AI Agent 在 2025 年及短期可预见的未来,真正落地、并帮我们赚到钱的形态。

如果这盆“冷水”让你对 AI Agent 有了更清醒的认识,点个「👍」,「转发」给更多还在淘金热中探索的同路人吧。

🌌 未来不属于 AI 的信徒,而属于 AI 的驯兽师。