引子:当 AI Agent 长出了“眼睛”和“手”

你好,我是果叔。

昨天,OpenAI 刚刚发布的智能浏览器 Atlas,无疑在 AI 圈和开发者社区造成了不小的轰动。在此之前,市面上已经涌现了诸多号称 AI Native 或 Agent 概念的浏览器,老实说,我尝试过不少,大多体验平平。

所以在实际体验 Atlas 之前,我的预期大概就是:可能和 Playwright 结合 Model Context Protocol (MCP) 的自动化方案比较类似,无非是 OpenAI 自家的模型和 Agent 框架与浏览器做了更深度的整合,理论上稳定性和兼容性会更好,相当于把工具调用内置了,速度也许会更快点?

最吸引我的一点是,它似乎提供了一种无需像 Claude Code 那样使用命令行或 IDE 的交互方式,这对我们这些非纯技术背景的用户显然会更加友好。毕竟,谁不想动动嘴皮子就把活儿干了呢?带着这份好奇,我第一时间上手,并测试了一个真实且复杂(对于 AI来说)的项目管理场景,它涉及到添加任务,填写多个任务字段,查找已有字段信息来正确选填来“拷问”Atlas 的真实能力。

初体验:IDE 式布局与 Agent 模式的惊艳

打开 Atlas,其界面布局并不算特别新颖:左侧是主要的浏览器操作区,右侧是一个熟悉的 Copilot 侧边栏。这种结构在 Perplexity Comet 等产品中也能看到。但 Atlas 的细节处理和交互逻辑,让我隐隐感觉到一种强烈的“IDE”感——仿佛浏览器不再仅仅是一个内容的“查看器”,而是一个复杂任务的“工作台”。这不禁让我思考:这种 IDE 式的布局,会不会是未来所有生产力软件的终极形态?至少,它清晰、可用。

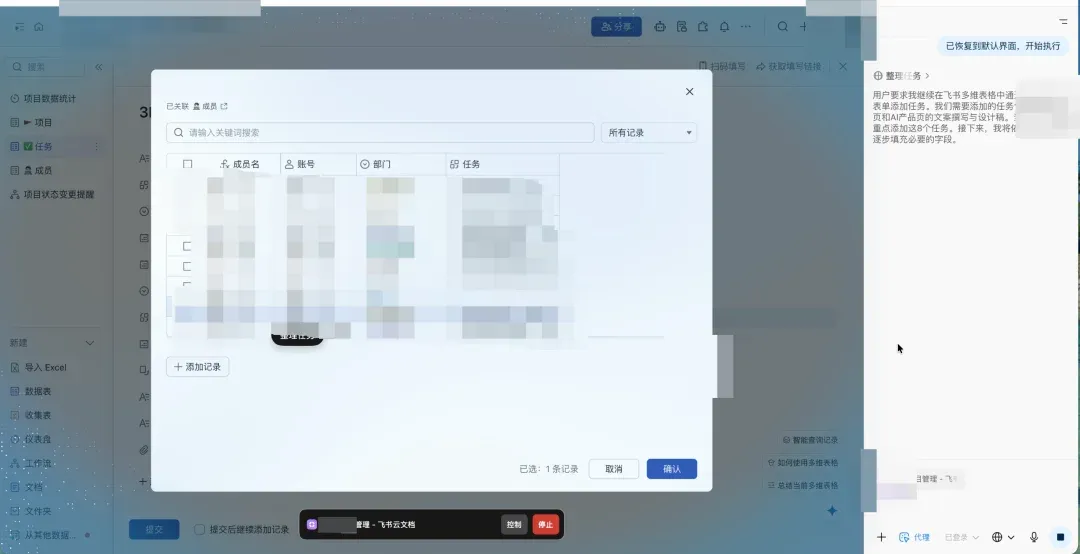

真正让我眼前一亮的,是它切换到 Agent 模式时的表现。当你授权 Atlas 操作浏览器时,整个界面会进入一个特殊状态:背景变为蓝色,屏幕上出现一个它专属的、会自己移动和点击的鼠标指针。指针旁边还会实时弹出文字气泡,告诉你它正在做什么:“正在点击添加记录按钮”、“正在填写任务名称”…… 这种可视化的执行过程非常直观,仿佛有一个透明的助手在你面前操作。

犹豫涉及真实项目生产环境,做了保密处理,见谅。

实战大考:让 Atlas 在某协作平台的多维表格里干项目经理的活儿

光说不练假把式。我决定给 Atlas 来个狠的:让它帮我处理一个真实的项目管理任务。

- 任务起点:

我先在该协作平台的云文档里用思维导图规划了一个网站(某 SaaS 平台官网)的结构框架。

- 第一步:任务拆解。

我让 Atlas 阅读这个思维导图,并总结出网站建设需要的任务清单,要求每个页面都拆解出文案撰写、设计稿、前端开发三个子任务。Atlas 理解得非常到位,迅速给出了一个结构清晰的任务汇总表。

- 第二步:表格创建(核心考验)。

我打开该协作平台对应的多维表格,然后,通过单次提示词,给了 Atlas 一系列极其复杂的指令,要求它在“按项目查看”的 Tab 下,通过点击“+添加记录”按钮,依次创建多个产品页的文案和设计任务。并且,在创建过程中,需要精准地填写多个字段:这个指令的复杂度在于:它不仅要求 Agent 理解自然语言,还需要它精准地在图形界面中定位元素(按钮、输入框、下拉菜单、特定项目名称)、执行多步操作(点击、输入、选择、确认、提交),并且要处理字段依赖和多选逻辑。

-

【任务】:填写任务名称(如:“xxx产品页文案撰写”)

-

【所属项目】:必须点击选择记录,找到并选中“Project Alpha 官网建设”

-

【状态】:所有任务选择“未开始”

-

【任务执行人】:所有文案任务分配给“小李”和“小张”(需要支持多选)

-

【优先级】:默认选择P2

结果与评价:能力惊艳,速度感人

最终结果如何?Atlas 磕磕绊绊,但最终完美地完成了所有任务!

但这个过程并不轻松。

- 速度是硬伤:

我让它总计创建了大约 10 个任务,花费了将近 30 分钟,平均创建一个任务需要 3 分钟。这个速度,坦白说,如果人来干这个事,可能也就花 3 分钟。

- 学习与自愈能力:

尤其是在第一次执行创建任务时,Atlas 明显遇到了困难,它在理解界面元素和执行流程时出现了错误。但最让我惊喜的是,它并没有卡死或放弃,而是自行进行了研究和修正(我没有进行任何人工干预),最终找到了正确的操作路径。后续的任务创建,明显比第一次流畅了不少。这展示了其 Agent 具备一定的自主学习和纠错能力。

- 产品化能力的胜利:

尽管速度不尽如人意,但 Atlas 在 Agent 模式下的可视化效果、对复杂指令的理解能力、以及最终任务的完成度,都给我留下了深刻印象。这让我更加确信:OpenAI 的模型也许在某些单项指标上不是最强的,但它做产品的能力,绝对是几家 AI 巨头里最顶尖的。它能够持续霸占 C 端用户量榜首(尤其是非 API 用户),绝非偶然。

对比 Comet:看似相似,实则云泥

作为 Perplexity Comet 浏览器的早期用户,我当初也是被它优雅的前端设计所吸引。乍一看,Atlas 和 Comet 的布局很相似,都是浏览器操作区 + Copilot 侧边栏。

但在实际体验了 Atlas 的 Agent 模式后,我只能说:Perplexity 的 Agent 产品化能力还是差太多了,这两玩意根本不是一个次元的产品。Comet 更像是一个信息获取和整理的助手,而 Atlas 则真正具备了在网页上“动手干活”的能力。因此,Comet 从来没有一天被我用作默认浏览器,而 Atlas 仅用了一天,就征服了我这个算是很挑剔的用户。并且每隔十几分钟就要进行人机验证的perplexity 真的对用户体验造成了毁灭性的打击。

深扒原理:Atlas 如何“看见”和“操作”你的网页?

作为一个产品佬,我无法忍住不去挖掘这个精致美丽且一点也不废物的产品背后的逻辑和原理。虽然这不是一篇技术向文章,还是简单带过一下。

为了搞清楚 Atlas 是如何做到这一切的,我特意“拷问”了它一番,并结合公开信息,大致还原了其底层原理:

1. 如何“看见”网页内容?(非 Agent 模式)

Atlas 并非真的去“访问”你正在看的网页。而是浏览器通过一个安全接口,将页面的结构化文本内容(DOM 文本快照)以只读方式发送给 ChatGPT 模型。这叫“本地网页上下文共享”。出于安全考虑,它无法读取你本地的文件 (file://)。

2. 如何“操作”网页?(Agent 模式)

当你授权 Agent 模式时,Atlas 浏览器会开放一个**“浏览器操作代理层”。ChatGPT 模型通过安全的 JSON 指令(如:{"action": "click", "selector": "button.add"})告诉这个代理层要执行什么动作(点击、输入等),然后浏览器自己在你的设备本地执行**这些操作。模型本身并不“远程控制”你的电脑。

3. 如何精准定位元素?(混合识别)

Atlas 同时使用了两套识别机制: - 结构化识别 (DOM 语义层): 优先使用,通过 HTML 结构(ID, class, 文本内容等)定位,速度快、精准。 - 视觉识别 (CV 层): 作为兜底,当页面是 Canvas、远程渲染或 DOM 不稳定时,通过截图进行 OCR 和 UI 元素检测来定位。 系统会自动融合这两种方式(Hybrid Targeting),确保稳定性和灵活性。

4. 虚拟鼠标和气泡如何实现?(前端渲染 + 同步)

你看到的酷炫效果,并非模型在操作,而是 Atlas 浏览器在本地前端实时渲染的可视化层 (UI Overlay)。模型发出指令 -> 浏览器执行操作 + 渲染动画 -> 浏览器反馈结果 -> 模型更新状态。这个过程通过“Command-Event Loop”机制严格串行同步,确保了动作和视觉效果的一致。

未来展望:当 Agent 替我们“动手”

这次体验,让我更加坚信:未来的软件形态,大概率会变成**“人下达指令 -> Agent 执行 -> 人审核”**的工作流程。这不仅仅局限于简单的网页操作,甚至可能渗透到大部分入门门槛很高的专业类软件中。

是的,目前 Atlas 花了 30 分钟才干完我 3 分钟能做完的事情,速度是硬伤。但其意义是完全不同的。模型能力会增强,速度会变快,工具生态会更加丰富,这些都是可以预见的趋势。

更重要的是,虽然我开一个浏览器让它干 30 分钟,而我只花了 1 分钟下达指令。那么,如果我同时开十个浏览器呢?100 个呢?当 Agent 的执行成本足够低、并行能力足够强时,也许未来真正制约我们生产力的,将不再是任务执行的效率,而是我们下达指令的效率了。 这无疑是一个值得所有 Builder 深度思考的方向。

觉得果叔的分析有启发?点个「👍」,「转发」给更多需要的朋友吧!

关注我的公众号,与你一同探索 AI、出海与数字营销的无限可能。

🌌 我们正在见证软件交互范式的又一次深刻变革。