**全文字数:**约 3500 字

**预计阅读时间:**约 10 分钟

**最后更新日期:**2025年08月25日

🤔 这篇文章适合你吗?

✅ 对 AI Agent 的高昂 Token 消耗感到困惑的深度用户。

✅ 想要理解 AI Agent 底层“思考过程”的技术爱好者与开发者。

✅ 计划在业务中引入 AI Agent 并需要进行成本评估的产品经理或决策者。

✅ 寻求有效策略以降低 Agent 使用成本的效率至上主义者。

📖 本文章节目录

**1. 引言:**我的“Token 震撼”时刻 🤯

**2. 基础设施:**管理成本的第一步

**3. 范式转移:**从“聊天”到“外包一个大脑”

**4. 认知循环:**Token 消耗的四幕剧

**5. 案例推演:**Token 是如何被“烧”掉的

**6. 结语:**我们到底在为 AI 的什么付费?

为什么AI智能体(Agent)会消耗天文数字般的Tokens?

1. 引言:我的“Token 震撼”时刻 🤯

你好,我是果叔。

作为一个 AI 深度用户和独立开发者,我对 Token 的消耗量向来敏感。但最近一次使用 Claude Code CLI 进行一个复杂任务的经历,还是让我体验了一次真切的“Token 震撼”。我只是给出了一个看似简单的指令:“分析这个 GitHub 仓库,总结其核心架构,并提出重构建议”。半小时后,任务完成得非常出色,但当我查看账单时,发现这个单一任务,竟然“燃烧”掉了超过 50,000 个 Tokens。

这个数字,相当于让模型写完半部《哈利·波特与魔法石》。这让我陷入了沉思:为什么看似简单的交互,背后却隐藏着如此惊人的消耗?这背后到底发生了什么?今天,我将从第一性原理出发,为你彻底解构 AI Agent “天价” Token 消耗背后的秘密。

2. 基础设施:管理成本的第一步

在深入分析成本结构之前,我们必须先解决一个更基础的问题:如何让这笔高昂的“投资”变得可控、可预测?一个账单模糊、服务不稳的平台,只会让成本问题雪上加霜。

正因为 AI Agent 的 Token 消耗巨大,我们才更需要一个专业的、能提供清晰计费和稳定性能的平台。这也是我向所有深度用户和团队推荐 Yoretea Claude Code (code.yoretea.com) 的核心原因。

- 账单清晰,成本可控:

它提供了明确的套餐和用量统计,让你的每一分投入都清清楚楚,便于进行成本核算和 ROI 分析。

- 性能稳定,避免浪费:

专线优化确保了 Agent 在执行多步复杂任务时,不会因为网络问题而中断或重试,这本身就是一种避免 Token 浪费的保障。

- 支付便捷,聚焦价值:

简单的支付方式,让你能把精力从应付繁琐的海外支付流程中解放出来,专注于如何最大化 AI Agent 的应用价值。

当你把 Agent 看作一名昂贵的“专家雇员”时,为他提供一个稳定、高效的“办公室”就显得至关重要。

同样,别忘了我的专属福利,可以帮助你更从容地开启 Agent 之旅:

果叔专属 8 折优惠码:GUOSHU

3. 范式转移:从“聊天”到“外包一个大脑” 🧠

要理解 Token 消耗的本质,我们必须先进行一次思维上的范式转移。

与 ChatGPT 进行一次普通的对话,好比是与一位知识渊博的专家进行 Q&A。你提问,他回答。这个过程的 Token 消耗,主要就是“问题”和“答案”本身的长度。

而使用一个 AI Agent,则完全不同。你不是在 Q&A,你是在外包一个完整的认知过程。这好比是你不再是简单地问专家一个问题,而是把一个项目 brief 扔给他,说:“去吧,搞定它,但你需要把自己所有的思考步骤、每次查阅资料的内容、每一次的决策过程,都以书面形式完整地记录下来,然后汇报给我。”

🔑 关键 take-away

AI Agent 的高昂 Token 成本,本质上是你为机器的**“思考过程透明化”**所支付的费用。我们看到的不仅是最终结果,更是它为了得出这个结果而进行的每一步推理、规划和工具调用。

4. 认知循环:Token 消耗的四幕剧 🎭

为了让这个过程更具体,我把它拆解为经典的 OODA 认知循环:观察 (Observe)、定向 (Orient)、决策 (Decide)、行动 (Act)。每一步,都是一个巨大的 Token 消耗点。

第一幕:观察 (Observe) - 绘制世界地图

在你发出指令的那一刻,你不仅发送了你的问题,还必须告诉 Agent 它所处的“世界”是怎样的。这包括把它能使用的所有工具的“说明书”(Tool Schema)全部传给它。这份说明书非常详尽,描述了每个工具的功能、参数、格式等。

**Token 消耗点:**你的指令 + 所有可用工具的详细定义文档。

第二幕:定向 (Orient) - 内心独白与战略规划

这是最核心、也最耗 Token 的部分。Agent 会进行一次“内心独白”(Internal Monologue)。它会把你的目标拆解成一个详细的步骤清单,分析每个步骤需要使用哪个工具,并规划好整个执行路径。这个过程,通常是以 XML 或 JSON 的格式,被完整地记录下来。

**Token 消耗点:**模型生成的、极其详细的、描述思考过程和行动计划的结构化文本(如 XML)。

第三幕:决策与行动 (Decide & Act) - 填写申请与汇报结果

对于计划中的每一步,Agent 都会生成一个精确的工具调用指令(比如一个 JSON 对象)。当工具执行完毕后,工具的返回结果(可能是另一个巨大的 JSON 数据,或一段代码,或网页内容)会完整地被反馈给 Agent,作为它下一步思考的依据。

**Token 消耗点:**N 次 [工具调用指令 + 工具返回结果] 的循环。这是乘法效应,极易造成 Token 爆炸。

第四幕:反思 (Reflect) - 总结陈词

在收集了所有信息后,Agent 会对所有中间步骤和结果进行一次最终的综合分析,然后生成我们看到的、条理清晰的、人类可读的最终答案。

**Token 消耗点:**模型对所有上下文进行最终推理,并生成结构化的最终报告。

5. 案例推演:Token 是如何被“烧”掉的 🔥

纸上谈兵终觉浅,让我们通过几个真实的案例,直观地感受 Token 是如何被消耗的。

案例一:分析一个中型 GitHub 仓库

假设任务是分析一个包含数百个文件的中型代码库。Agent 的思考过程和 Token 消耗可能如下:

认知阶段

具体动作

Token 消耗估算

观察

用户指令 + Git/文件/代码分析等多个工具的 Schema 定义。

~2,500 Tokens

定向

生成复杂的内心独白,规划出遍历、读取、分析、总结等数十个步骤。

~5,000 Tokens

行动

调用 ls -R 列出庞大的文件树,返回结果。

~15,000 Tokens

循环调用 cat 读取 10个核心文件的内容,返回结果。

~40,000 Tokens

调用代码分析工具,返回复杂的依赖图谱 JSON。

~8,000 Tokens

反思

整合所有信息,撰写一份极其详尽的分析和建议报告。

~15,000 Tokens

总计

~85,500 Tokens

案例二:从“一句话”到一个贪吃蛇游戏

这个案例更进一步,它展示了在多轮迭代开发中,Token 是如何“滚雪球”的。用户只说了一句“请你帮我创建一个贪吃蛇游戏”,Agent 就开始了一系列规划、编码、修正的循环。

认知阶段

具体动作

Token 消耗估算

初始规划

用户指令 + 工具 Schema -> 生成包含6个步骤的 TODO List。

~2,500 Tokens

多轮迭代开发 (上下文累积效应)

在 4-5 轮循环中,Agent 不断地:1. 更新 TODO 状态 2. 编写/修改代码 (snake_game.html) 3. 接收执行结果。在每一轮,它都必须将之前的全部对话历史和已生成的完整代码作为上下文重新发送,导致 Token 消耗急剧膨胀。

~120,000 Tokens

最终交付

完成所有 TODO 任务,并给出最终的确认信息。

~5,000 Tokens

总计

~127,500 Tokens

这个案例生动地揭示了 Agent 模式下最恐怖的成本陷阱:上下文雪球。为了保持任务的连贯性,每一次交互都是在前一次的基础上进行的,这导致了 Token 消耗的非线性增长。

案例三:真实的成本账单——不止是 Claude Code

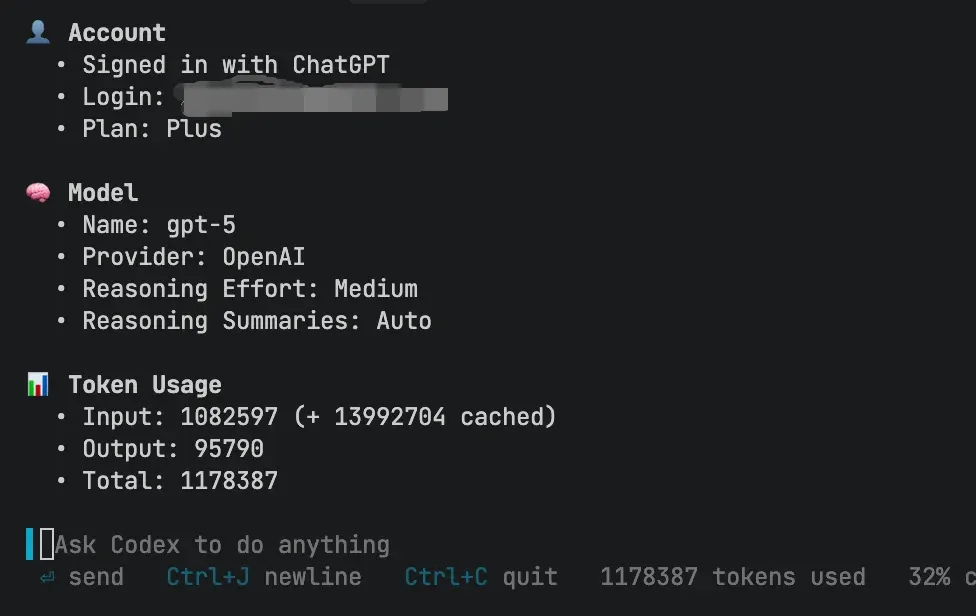

你可能会想,这只是 Claude Code 的特例吗?恰恰相反。这几乎是所有高级 AI Agent 系统共同的“物理定律”。为了验证这一点,我最近用另一款名为 Codex 的 Agent,对我自己的博客站进行了一些小修小改,整个过程大约一小时。

结果让我倒吸一口凉气。请看这张消耗报告。输入 Tokens,如果算上为了维持上下文记忆而产生的缓存(cached),总数竟然飙升到了惊人的 1500 万 以上!

天文数字般的 Tokens 最终会转化为真实的账单。我曾经也尝试过一些看似廉价的国产替代方案,比如阿里云百炼的 Qwen Coder,但很快就因为高昂的“缓存 Token”计费而收到了欠费提醒。我们来看看它的价格模型,你会发现,对于 Agent 这种动辄百万 Token 消耗的场景,真正决定成本的,是高用量区间的价格,以及那个不起眼的“命中缓存输入价格”。

简单匡算一下,我那一小时不到的博客站修改工作,如果放在这个平台上,账单可能就高达数十元。这还只是一个人的、一小时的、小修小改的工作!这清晰地揭示了一个事实:Agent 的强大能力,是以巨大的计算资源和 Token 消耗为代价的,无论你使用哪家的服务,这个底层逻辑都无法改变。

同时我也感觉真正的AI 科技平权还远未到来,目前这些AI 工具的使用价格是如此昂贵,这意味着一部分人群会被排除在外。而这之间带来的巨大生产力的差距,又会进一步加剧收入的分化。

6. 我们到底在为 AI 的什么付费?

理解了 AI Agent 的 Token 消耗机制后,我们应该得出一个清晰的结论:我们支付的,并不仅仅是“答案”的成本,更是购买机器“结构化思考过程”的成本。

这笔“费用”换来的是传统 AI 无法给予的核心价值:自主规划、工具调用、以及解决复杂问题的能力。这是一个从“知识问答”到“任务执行”的巨大飞跃。

因此,作为驾驭者,我们的策略也应随之改变:

- 精确定义目标:

模糊的指令会让 Agent 进行大量无效的探索,燃烧掉海量 Token。指令越精确,它的思考路径越短,成本越低。

- 选择合适的工具:

杀鸡焉用牛刀。简单的文本生成任务,就不需要动用复杂的 Agent 模式。

- 关注 ROI 而非绝对成本:

思考这个 Agent 任务为你节省了多少小时的人工劳动。如果它用 100,000 Tokens(约几块钱到十几块钱的成本)完成了你半天甚至一天的工作,那这笔投资的回报率是惊人的。

觉得果叔的分析有启发?点个「在看」,「转发」给更多对 AI 感到好奇的朋友吧!

关注我的公众号,与你一同探索 AI、出海与数字营销的无限可能。

🌌 我们正在进入一个为“机器思考”付费的时代,学会管理和驾驭这种思考,将是未来十年最重要的能力。